Am 15. April 2014 sendete RTL einen kritischen Beitrag über die Arbeitsbedingungen in Zalandos Logistik Center in Erfurt. Der Vorwurf: Unmenschliche Zustände. Angelastet wurden dem Unternehmen insbesondere die enge Überwachung bis Bespitzelung der Mitarbeiter sowie körperlich zu anstrengende Tätigkeiten (über 20km Laufpensum am Tag).

Berichtet und aufbereitet hatte dies eine junge Journalistin (Caro Lobig), die im Günter-Wallraff-Stil (und mit Wallraff-Unterstützung) drei Monate undercover und investigativ dort gearbeitet und auch verdeckt gefilmt hatte. Mittlerweile hat sich das Thema zu den Gerichten verschoben (einstweilige Verfügungen & Co) – mit kleinen Punktsiegen für Zalando. Doch begonnen hatte es medial-viral:

Denn dieser RTL-Bericht löste einen kleinen Shitstorm im Social Web aus.

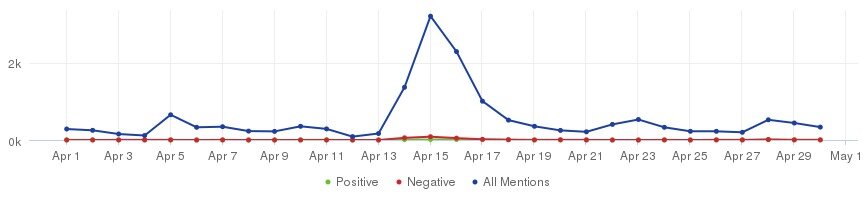

Der Zalando-Buzz-Verlauf sah im April 2014 so aus – ausgewertet mit dem Social Media Monitoring Tool “Brandwatch“.

Für diese Grafik wurde schlicht nach Kundenäußerungen zu “Zalando” gesucht. Etwas konkreter:

Für diese Grafik wurde schlicht nach Kundenäußerungen zu “Zalando” gesucht. Etwas konkreter:

- Der verwendete query-string lautet “zalando NOT (beteiligung OR aktie OR boerse OR kurs OR bewerbung OR stellenausschreibung OR lebenslauf OR job OR praktikum OR praktika OR akademiker)”

- Ausgewertet wurden nur deutschsprachige Seiten

- Gefiltert wurde dann nur nach den Medien Twitter, Facebook, Blogs und Foren.

Über 16.000 Mentions wurden via Brandwatch im April 2014 mit diesen Parametern gefunden. Automatisch erkannte das Tool darunter knapp 90 positive und 270 negative Statements.

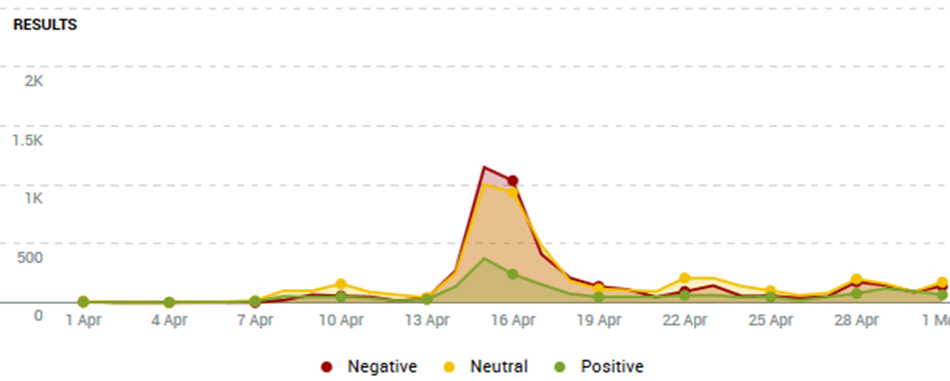

Mit den gleichen Such-Parametern haben wir auch das Werkzeug “talkwalker” gestartet, so sieht das Ergebnis dort aus:

Beide Kurvengruppen sind ähnlich – aber gleich sind sie durchaus nicht. Besonders auffällig:

- Brandwatch findet 97% neutrale, 2% negative und 1% positive Beiträge

- bei talkwalker sind es 44% neutrale, 39% negative und 17% positive Beiträge

Wie können solche gewaltigen Unterschiede entstehen?

Bei Brandwatch ist man, was die Sentiment-Erkennung (so nennt man die Einteilung in positiv-neutral-negativ) angeht, in der Grundeinstellung recht vorsichtig. Was nicht eindeutig als gut oder schlecht erkannt wird, kommt in den großen Top “neutral”. (Man kann die Regeln hierzu allerdings individuell anpassen.)

Der Vorteil bei diesem Verfahren: die Fehlerrate (und die gibt es auf jeden Fall!) ist selten gravierend. Gravierend, das wäre “positiv erkannt, de facto aber negativ” – oder umgekehrt. Wer nur die ganz sicheren Kandidaten rot oder grün einfärbt, muss schlimmstenfalls gelegentlich auf gelb (neutral) wechseln.

Der Nachteil: Der gefährliche Shitstorm wird auf den ersten Blick kaum erkannt. Den “Storm” sieht man: kräftiger Anstieg im “Buzz” – doch er scheint harmlos zu sein. So könnte es vielleicht auch bei einer besonders kreativen Promotion aussehen.

Nur wer um die Zurückhaltung von Brandwatch an dieser Stelle weiß, kann sich seine Alerts entsprechend sensibel einstellen. Der absolute Anstieg der Mentions um mehrere 100% zusammen mit einem Verhältnis von 3:1 negativ zu positiv (270:90), so ungefähr könnte eine Shitstorm-Warnfunktion aussehen.

Das heißt: Man muss das eingesetzte Monitoring-Schiff und seine Eigenheiten recht gut kennen, um zuverlässig über den Social Media See zu navigieren.

Wie gut, wie zutreffend ist nun die Sentiment-Erkennung eines solchen Tools?

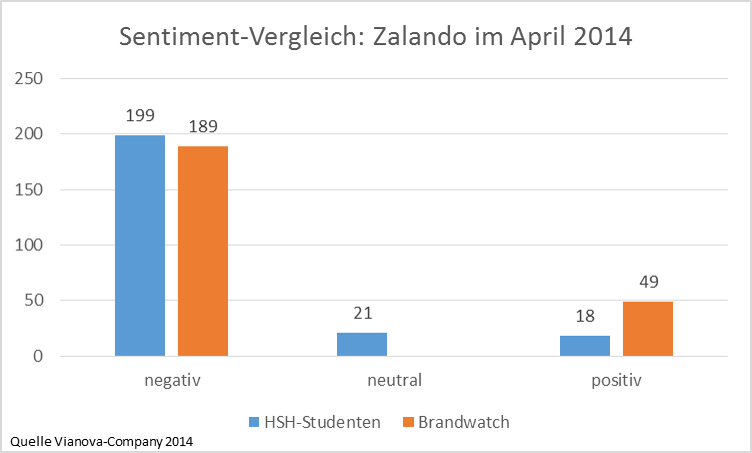

Wir haben uns die von Brandwatch gefundenen Mentions mit eindeutiger positiv-negativ-Zuordnung dafür genauer angeschaut und manuell erneut ausgewertet. Im Rahmen einer Veranstaltung an der Hochschule Hannover am 5.5.14 (eine Mischung aus Vorlesung und Seminar) haben rd. 40 Studenten, die leitende Dozentin Frau Professor Christa Seja und der Autor alle 353 (86 + 267) Beiträge entsprechend gelesen und begutachtet.

Das Ergebnis war überraschend gut.

Von den 238 als relevant eingestuften Posts, Tweets & Co wurden die “negativ-eingefärbten” in großem Umfang korrekt erkannt. In 10 Fällen war das automatische Urteil “positiv” grob falsch, richtig wäre nach manueller Prüfung “negativ” gewesen. In 21 Fällen wurde auf neutral erkannt (statt auf “positiv”, wie Brandwatch das automatisch erkannt hatte). Rechnerisch sind das 13% Fehlerkennung – ein ausgezeichneter Wert.

Die Anbieter von Social Media Monitoring Tools selbst geben ihre Erkennungsgenauigkeit meist eher etwas schwammig mit “um die 70%” an.

Wer sich schon etwas länger mit dem Thema “Sentiment-Erkennung” beschäftigt hat, weiß natürlich, dass dies eines der heikelsten Kapitel des Social Media Monitorings ist. Hier Verlässlichkeit und Belastbarkeit zu erwarten, ist schlicht ein Fehler. Die Tools liefern solche Auswertungen – aber die Qualität der Ergebnisse ist oft sehr fraglich. Wir haben hier zu diesem Thema schon einige Beiträge geschrieben.

Umso erfreulicher ist es, dass die hier im Falle Zalando angetroffene Sentiment-Erkennungs-Qualität recht hoch war.

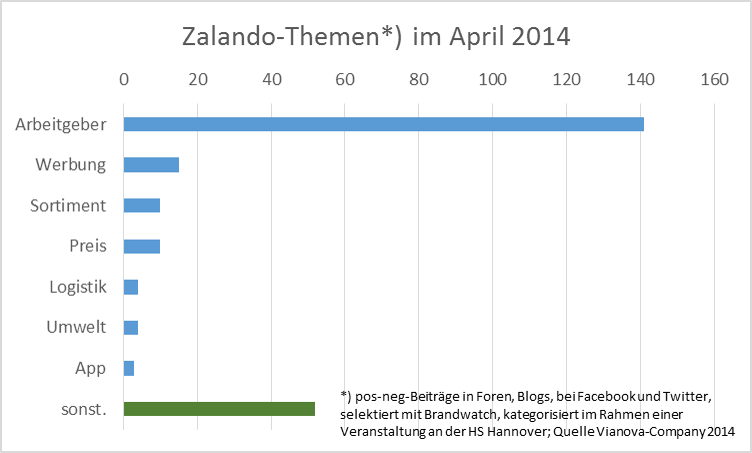

Die Studenten haben die als relevant erkannten Posts außerdem noch thematisch “getagged”, kategorisiert, nach Themen sortiert.

Sehr deutlich ist hier die Wirkung des RTL-Beitrags zu sehen, das dominierende Thema ist Zalandos Rolle als Arbeitgeber. Fast alle Beiträge zu diesem “Tag” sind negativ, ebenso ist es beim Thema “Umwelt” (beides nicht dargestellt).

Die Marketing-fachliche Betrachtung beginnt an diesem Punkt eigentlich erst: in welchen Medien wird wie und worüber gesprochen, welche Beiträge sind besonders viral, welche Autoren haben große Audience? – und Vieles mehr.

In der Hochschul-Veranstaltung hatten wir allerdings eher methodische Ziele. Und die haben wir weitgehend erreicht. Denn die Studenten haben im Zuge ihrer Auswertungsarbeiten zum Sentiment wie auch zu Themen und Tags sehr praktisch erfahren:

- Automatische Sentiment-Erkennung ist entweder recht präzise oder weitgehend vollständig. Die babylonische Kakophonie im Social Buzz mit all den Tippfehlern, Slangausdrücken, Mehrdeutigkeiten, Spezial-Idiomen, Sarkasmen, ironischen Formulierungen etc. stellt eine zu große Hürde dar, als dass man beides in der sonst üblichen und vom Management erwarteten Zuverlässigkeit bekäme.

- Ähnliches gilt für die automatische, regelbasierte Themenerkennung. Bei Brandwatch kann man zwar solche Regeln definieren, doch schon die kleine Stichprobe aus unserem konkreten Beispiel-Case hat hier klare Grenzen bei der Regeldefinition aufgezeigt. Eine einfache Themenregel könnte etwa so aussehen: “(Arbeitsbedingung* OR Mitarbeiterführung*) NEAR/5 (schlecht* OR unmenschlich* OR unzumutbar*)”. Sie hätte zwar nicht alle unsere Treffer zu “Arbeitgeber” gefunden, aber uns die Arbeit abgenommen. Auch hier steht man vor der Wahl: präzise oder vollständig?

Was also ist zu tun angesichts dieser Einschränkungen?

Offensichtlich sind Social Media Monitoring Tools für die Marketing-Navigation im Social Web und entsprechende Markenführung unerlässlich. Man braucht sie für die Markt- und Medienbeobachtung, die Kundenbetreuung, die Wettbewerbsanalyse, als Frühwarnsystem und für das Qualitätsmanagement (der letzte Punkt wird oft übersehen).

Um die relevanten Beiträge aus den vielen Millionen Webseiten, News-Channels, Blogs, Foren und sozialen Netzen nahezu in Realtime laufend abzuziehen, sind diese Werkzeuge alternativlos.

Doch bei der Auswertung und Analyse des gehobenen Schatzes ist Vorsicht geboten. Auf die beiden einfachen und naheliegenden Fragen: “was ist gerade angesagtes Thema?” und “wie kommen wir dabei weg?” bekommt man zwar schnell Antworten – aber kann man sich auch auf sie verlassen? Von diesen Antworten Entscheidungen abhängig machen?

Ohne eine regelmäßige Qualitätsüberprüfung und -sicherung wäre das fahrlässig. Wer belastbare Findings sucht, muss gerade diese fachlichen Erkennungstools laufend kalibrieren. Wiederkehrende manuelle Auswertungen von Stichproben, so lästig sie sind, sind unbedingt erforderlich.

Angenehmer Nebeneffekt: man kann durchaus Diamanten in der Goldmine finden. Die Themengruppe “Sonstiges” (in unserem Beispiel mit 50 Nennungen immerhin die zweitgrößte) enthält all die Beiträge, deren Gegenstand in kein bekanntes Raster passt. Das sind mitunter neue Themen, die neue Ideen, neue Wünsche und Anforderungen oder auch neue Probleme und Gefahren indizieren.

Fazit

Marketing ohne Social Media Monitoring Tools ist heute nicht mehr möglich. Doch der Social Buzz ist nur bedingt automatisch analysierbar. Begleitende manuelle Auswertungen sind unbedingt erforderlich. Sie

- öffnen das Blickfeld für neue Themen

- sind notwendig, um die Regeln und Sentiment-Erkennung zu kalibrieren

- vermitteln in ihrem ungeschminkten O-Ton ein Gefühl für den “Sound” da draußen und die Stimmung in der Kundschaft.

Jeder Marketing-Verantwortliche sollte sich diese Lektüre von Zeit zu Zeit gönnen.

Wenn Sie Fragen, Anmerkungen oder auch Korrekturwünsche hierzu haben: immer gerne!

Uns interessiert besonders, welche Erfahrungen Sie in Sachen Texterkennungs-Qualität mit welchem Social Media Monitoring Tool gemacht haben. Welcher Anbieter ist da aus Ihrer Sicht führend?

Hinterlasse eine Antwort